Deep Learning 其實與我們沒有那麼遙遠,因為我們都在為其學習教材貢獻一份心力

今年在 GTC 活動上,將去年所談論的 Machine Learning 更進一步的提升到進階的 Deep Learning 深度學習,這也是由於今年初 Google 、微軟與百度透過深度學習在圖像辨識領域有了重大的突破,儼然掀起了深度學習的技術戰爭;乍看下深度學習與我們的生活好像有那麼些遙遠,但其實每個網路使用者幾乎無時無刻都在為深度學習貢獻素材。

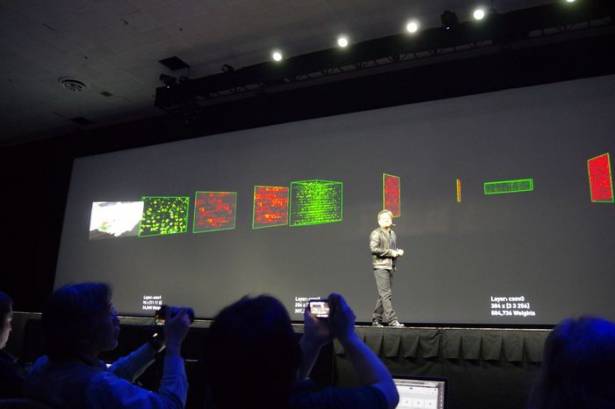

所謂的深度學習,是透過神經網路學 Neural Network 的運算模型的技術,關於深度的技術筆者也不是那麼了解,但該技術相較傳統熟知的人工智慧技術,重視的不是為了因應各種情形撰寫對應的邏輯,而是讓系統模仿人類的感知,透過不斷投入素材進而從中解析產生認知;在透過充裕的素材下,在理論上基於足夠的運算力,可達到模擬人類認知的行為。

這套理論起源已久,不過一直到近年才又獲得重視,因為如前所述,這套理論需要具有充裕的學習素材以及運算能力,然而早年資料樣本蒐集不易,基於純 CPU 的運算系統又未能提供解析大量數據的能力。

故使深度學習理論能夠突破的關鍵在基於網際網路的大數據蒐集分析,以及透過 GPU 運算的運算中心架構成熟。從大量數據的蒐集與解析中找出有效樣本,再透過結合 GPU 的運算架構達到具感知力的運算;且去年 GTC 即提過,透過高效能的 GPU 架構,如今僅需結合數張基於 Kepler 或是 Maxwell 架構的 GPU ,已經有媲美甚至超越數年前超級電腦的運算力。

然而在深度學習理論,正確的素材是相當重要的,除了最先前由工程人員選出的正確素材之外,使用者的網路使用行為也成為遴選素材的重要來源;為何會這樣說?舉個簡單的例子就像是 Facebook 的照片中好友標記,說穿了就是一種學習素材的建立。

以辨識人像的圖片分析行為來說,系統邏輯會先由定義照片中的物體開始,把一張照片中的物件進行初步的辨識,找出那些符合構成人臉的要素;接著就是由使用者經常上傳的照片進行解析,試圖將使用者個人照片中的人臉建構符合的邏輯,接下來就是嘗試自動為使用者進行標記的動作。

然而在嘗試自動標記的行為中,其他使用者的互動也成為確認深度學習素材的重要條件;回想一下初期 Facebook 的照片好友識別,會有兩種情況,一種是只找出人臉請使用者下標籤,另一種是嘗試提供人名的標籤詢問對錯。前者的標示行為將會成為基礎素材,後者則是用於判斷系統對於這個人的人臉構成元素邏輯是否正確。

當系統蒐集足夠的素材後,就會開始自動進行下標籤的動作,然而使用者被詢問是否進行標籤該人物時,如果選擇了否,就意味著這張照片的人物標籤可能是錯的,當有許多的人看到這張標籤都選擇了不符合正確標籤敘述時,系統就知道針對這個人物的感知邏輯有誤,將會把錯誤的照片與邏輯再度進行比對,並使認知邏輯再進化。

這也意味著,當越多人針對照片標籤的對錯按下按鍵,系統對於該人物的感知邏輯就更為完整;不知道各位是否有注意到,相較於前幾年 Facebook 的好友照片標籤標註,最近的準確率越來越高,這也是要感謝越來越多人給予系統正確的素材,以及幫忙系統分辨哪些是錯誤的資訊。

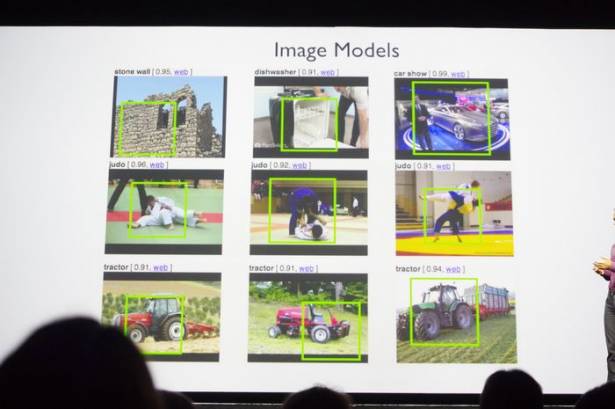

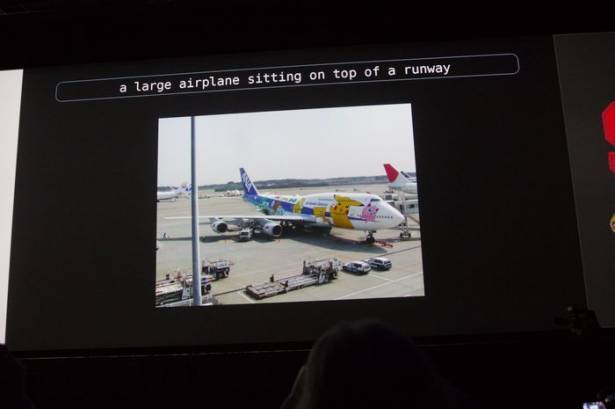

而圖像辨識的另一個進階應用,就是以圖找圖;以圖找圖的概念,就是能為照片中的元素進行拆解以及邏輯敘述,故以圖找圖需要建立在對於眾多事物的感知邏輯,系統要知道大量的事物,宛若人類看到一張照片後能夠以一句話敘述照片內容。

也就是說,系統要能把照片中的大量敘述標籤建構出一句話,例如"有一隻綠色的胖松鼠在吃頂呱呱的炸雞",就需要知道照片中有包含”綠色”的"胖松鼠"在”吃””頂呱呱"的"炸雞",看似簡單的一句話,卻要在能夠辨別包括綠色、松鼠、吃的動作、頂呱呱的標誌以及炸雞等事物才能完成。

當能為照片下正確的註解,就能在以圖找圖時不僅是透過圖像比對,而是藉由從資料庫中撈出符合這些敘述的照片作為"類似這張照片的照片",所以近年在使用以圖找圖時,已經不光是透過解析照片輪廓找到近似的照片,而是真正從照片的敘事標籤中找到擁有類似敘述的照片。

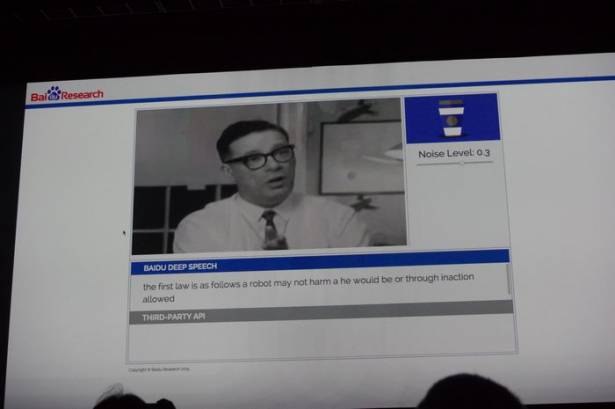

另一個深度學習的戰場則是語音辨識後的搜尋,以前的語音搜尋方式是在上傳聲音後找到關鍵詞彙進行搜尋,然而由於使用者發音的正確性、系統並未理解完整的句子僅是以關鍵詞彙判讀語意,故語音搜尋的正確性相當的糟糕。

但導入深度學習後,語音辨識的方式則是先將語音內容拆解為發音的音節,先從辨識音節開始,才將發音音節以及斷句構成詞彙,接著經由詞彙構成完整的句子,最終分析句子的語義後才進行搜尋。

這樣的應用除了基本的語音搜尋外,還被廣泛應用在語音助理如蘋果的 Siri 以及微軟的 Cortana 上,語音助理也是語音辨識的延伸應用,且相較於傳統的語音搜尋,語音助理還可獲得更多使用者的自然語意。且如百度的詞彙庫還可經由旗下的服務,如百度知道、百度貼吧中撈出最新的流行語作為資料庫。

你或許會喜歡

![Google新推官方App: “Newsstand”為你找出最有興趣的資訊 [影片]](https://www.iarticlesnet.com/pub/img/article/4947/1403807063577_xs.jpg)